360智脑7B大模型开源,长文本处理能力达50万字

|

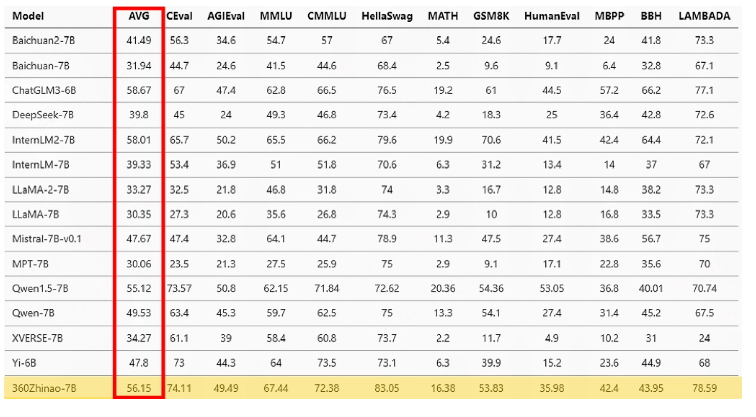

4月13日消息,360公司近日在GitHub上公开了其360智脑7B(70亿参数模型),这一大模型是基于3.4万亿Tokens的语料库进行训练的,主要涵盖了中文、英文和代码。该模型提供了4K、32K、360K三种不同的文本长度选项,其中360K(大约50万字)被360自称为当前国内开源模型中最长的文本长度。 360在多个主流评测数据集上,包括C-eval、AGIeval、MMLU、CMMLU、HellaSwag、MATH、GSM8K、Humaneval、MBPP、BBH以及LAMBADA,对其模型性能进行了全面验证。这些评测主要考察了模型的自然语言理解、知识储备、数学计算和推理、代码生成以及逻辑推理等能力。结果显示,360模型在四个评测数据集上取得了领先的排名,整体平均成绩位列第三。 在专门为大语言模型设计的长文本理解能力评测基准LongBench中,360选择了与中文长文本应用最为相关的任务进行测试。结果显示,360Zhinao-7B-Chat-32K模型在中文单文档问答、多文档问答、摘要以及Few-shot等任务中取得了平均第一的好成绩。 同时,在英文大海捞针测试以及360自行构造的中文大海捞针测试中,360Zhinao-7B-Chat-360K模型均达到了98%以上的准确率,显示出优异的长文本处理能力。 除了模型权重之外,360还开源了该模型的微调训练代码和推理代码等全套工具集,使得大模型相关开发者能够非常方便地使用这些资源,实现开箱即用。 据本站了解,360公司董事长周鸿祎曾表示,大模型行业在文本长度上有所追求,100万字将很快成为行业的标配。他透露,360之所以将模型文本长度定为360K,并选择开源这一能力,是为了让整个行业能够共享这一成果,避免重复劳动。周鸿祎自称是开源的信徒,坚信开源能够推动行业的进步。 |